От автора

Вы знаете, что администратор Интернет магазина, может управлять не только сайтом магазина, но и управлять поведением веб-серверов и поисковых ботов. Для первого управления служит файл .htaccess, для управления поведением поисковых ботов служит специальный файл robots.txt. Что такое файл robots и как составить файл robots.txt для OpenCart 3 в этой статье.

Что такое файл robots.txt

Формально, файл robots.txt это текстовой файл в кодировке UTF-8, составленный по определенным правилам. Нужен этот файл для управления поведением поисковых ботов, которые посещают сайт. С его помощью вы можете закрывать страницы, разделы, весь сайт от сканирования поисковыми ботами.

Для чего нужен файл роботс

Можно часто встретить мнение, что инструкциями в файле robots вы закрываете от сканирования части сайта или сайт полностью. В результате закрытые страницы сайта выпадут из индекса поисковиков, и будет достигнута цель такого закрытия.

Это не совсем так. Например, поисковик Яндекс действительно, воспринимает запретные директивы файла robots.txt буквально и не только перестает обходить закрытые страницы, но и выводит их из индекса и выдачи.

В отличие от него, поисковик Google только перестает обходить закрытие части сайта. Файлы (страницы) сайта которые уже попали в индекс и выдачу, GoogleBot выводить из индекса не будет. (источник)

Это значит, что страницы магазина, которые уже попали в выдачу Google, закрывать в файле robots.txt бесполезно и даже вредно. Для таких страниц работает только мета-тег “Robots”.

Директивы файла robots

Понятно, что для составления файла robots существуют специальные правила. Давайте посмотрим, основные их них.

Составляется файл блоками. Каждый блок начинается с инструкции User-agent:. В ней прописывается обращение к конкретному поисковому роботу или группе роботов, которым следует читать правила этого блока.

Правила для поисковиков прописываются в каждом блоке, директивами Disallow и Allow. Директива Disallow сообщает роботам о запрете сканирования, Allow, наоборот, рекомендует роботу обойти файлы сайта, прописанные в этой директории.

Кроме этих основных директив, есть специальные директивы для специальных инструкций поисковикам. Например, директива Crawl-delay ограничивает частое сканирование сайта и снижает нагрузку поисковиков на сервер. У Яндекс есть специфические директивы: Crawl-delay и Clean-param (о них читать тут)

Как составлять файл robots.txt для OpenCart 3

Во-первых, файл robots.txt нужно составлять в текстовом редакторе типа Notepad. Кодировка файла UTF-8 без BOOM.

Блок директив для всех потенциальных ботов Интернет, должен начинаться с такой инструкции:

User-agent: *

Для Яндекс, лучше составить отдельный блок директив. Он должен начинаться с инструкции:

User-agent: Yandex

Чтобы закрыть весь сайт магазина от сканирования, а это нужно делать сразу после установки Opencart, достаточно сделать такой файл robots:

User-agent: *

Disallow: /

,если магазин лежит в корневом каталоге. Или

User-agent: *

Disallow: /opencart

,если магазин лежит в подкаталоге opencart.

После составления файла роботс, его нужно по FTP положить в каталог, где лежит OpenCart.

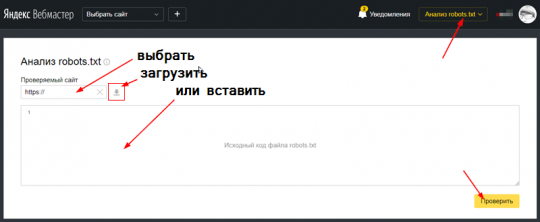

Как проверить файл robots.txt для OpenCart 3

Нарушение правил составления файла и ошибки синтаксиса будут неоднозначно пониматься поисковыми ботами, что недопустимо. После составления сложных файлов robots, их нужно проверить на специальных серверах. Вот лучшие из них.

Во-первых, откройте в браузере сам добавленный файл. Для этого откройте файл ваш_магазин.ru/robots.txt. Вы должны увидеть ваш файл robots.

Важно, проверить файл в инструментах веб-мастеров Яндекс (тут) и Google (тут) есть специальные инструменты проверки ошибок в файле robots. Для использования этих инструментов, вам нужно получить аккаунты и добавить свой магазин в инструменты.

Если, по каким либо, причинам, вы не работаете с инструментами вебмастеров, воспользуйтесь для проверки одним из валидаторов robots.txt.

- Seochat: Общая проверка по всем ботам

- Technicalseo: Выборочная проверка по отдельным ботам.

- Lxrmarketplace: Проверка по URL или загрузке файла.

- Visiospark: Мощный валидатор и генератор

- Еще: Duplichecker

Генераторы robots

Эти инструменты помогут составить правильные файлы индексации.

Файл robots.txt для OpenCart 3

Предлагаю для использования следующий файл robots.txt для OpenCart 3.

Откройте страницу и скопируйте файл для изучения и возможно, использования. Не забудьте переименовать.

Вывод

В этой статье я рассказал о файле robots.txt и дал образец файла robots.txt для OpenCart 3 от разработчиков русского опенкарт.

©shopiweb.ru

Еще статьи

- Способы оплаты на OpenCart по умолчанию

- OpenCart Cloud: интернет магазин OpenCart на облачном сервере

- Что изменилось в OpenCart 4.0.1.1

- Как установить OpenCart 2.0 на практике

- Основы управления магазином OpenCart

- Как восстановить пароль администратора OpenCart

- Макеты Opencart

- Перевод AceShop на русский язык

- Установить шаблон OpenCart

- Настройка доставки товаров в OpenCart

- Ускорение Opencart, подсчет количества товаров

- Установка OpenCart 3 на хостинг, 2018 год

Данный роботс подходит и к opencart (окстор) 3 и opencart 2?